Dlaczego mojej strony nie ma w Google? To pytanie spędza sen z powiek nie tylko świeżo upieczonym właścicielom witryn. Czasem zdarza się, że na skutek niefortunnych zdarzeń, z wyszukiwarki Google znika strona z dłuższą historią. Jeszcze kilka lat temu brak widoczności strony internetowej wynikał głównie z problemów technicznych lub niedostatecznego SEO. Dziś sytuacja jest bardziej złożona, bo oprócz klasycznych wyników wyszukiwania Google coraz częściej prezentuje użytkownikom gotowe odpowiedzi generowane przez sztuczną inteligencję w AI Overviews oraz w trybie AI Mode, które skracają drogę do informacji i ograniczają liczbę kliknięć w linki. A to oznacza, że strona niewidoczna w wynikach wyszukiwania może być efektem nie tylko błędów indeksowania, ale także niskiej jakości treści, którą Google oraz systemy AI pomijają podczas generowania podsumowań.

W tym artykule znajdziesz 10 najczęstszych powodów braku widoczności strony, uwzględniających to, jak działają roboty indeksujące Google oraz jak AI ocenia treść strony internetowej. Dowiesz się również, dlaczego jej indeksowanie jest dziś tylko jednym z elementów sukcesu.

Z czym wiąże się strona niewidoczna w sieci?

Widoczność strony internetowej może spaść w jednej chwili – czasem na skutek drobnego błędu technicznego, a czasem dlatego, że Google już jej nie potrzebuje, by odpowiedzieć użytkownikowi. Dlaczego tak się dzieje? Bo coraz częściej pierwszą odpowiedzią nie są linki, lecz AI Overviews i AI Mode, czyli podsumowania generowane przez modele językowe Google. A to prowadzi do tego, że brak widoczności strony to nie tylko sytuacja, w której Google nie indeksuje strony.

Dziś oznacza to również:

- brak obecności w odpowiedziach AI Overviews i AI Mode,

- pominięcie treści przez modele AI jako niewiarygodnych lub mało użytecznych,

- ograniczoną ekspozycję w SERP-ach mimo braku błędów technicznych,

- brak ruchu z fraz long-tail, które są teraz głównym paliwem dla AI Mode.

Google nie informuje wprost, że Twoja treść została zignorowana przez AI, ale spadek ruchu, mniejsza liczba wyświetleń i brak pozycji w raportach Google Search Console to czytelne sygnały tej sytuacji.

Dlaczego SEO nie kończy się dziś na indeksowaniu strony?

Według raportu Search Engine Journal (2024) nawet 58,7% zapytań informacyjnych w USA otrzymuje AI Overviews*, a Europa jest kolejnym rynkiem, który masowo wdraża te rozwiązania.

Choć wysokie pozycje organiczne w Google pozostają nadal istotne, to biorąc pod uwagę fakt, że 75% wzmianek w serwisie AI Overview pochodzi z 12 najlepszych stron**, firmy muszą dostosować swoje strategie do rosnącej roli sztucznej inteligencji w wyszukiwaniu.

Oznacza to, że:

- użytkownik może nie dotrzeć do serwisu nawet wtedy, gdy masz dobrą pozycję organiczną,

- treść o niskiej jakości treści (thin content) jest automatycznie pomijana,

- duplicate content, czyli powielone treści ograniczają widoczność strony nie tylko w SERP-ach, ale także w AI,

- roboty Google oceniają stronę nie tylko pod kątem technicznym, ale też semantycznym.

Kiedy warto zadbać o widoczność swojej strony?

Problem braku widoczności strony internetowej dotyczy każdego przedsiębiorcy, którego biznes opiera się na ruchu organicznym. Najbardziej narażone są sklepy online, nowe strony internetowe, lokalne firmy, a także branże o wysokiej konkurencyjności, gdzie algorytmy Google i roboty indeksujące Google dokładnie analizują każdą treść strony internetowej. Jeśli Twoja witryna generuje sprzedaż lub pozyskuje leady, utrata widoczności strony oznacza realne ryzyko spadku przychodów.

Szczególną uwagę powinny zwrócić na to firmy, które po wdrożeniu zmian odnotowały nagły spadek w wynikach wyszukiwania Google, zauważyły problemy z indeksowaniem strony internetowej lub w raportach Google Search Console pojawiły się komunikaty o błędach, które blokują indeksowanie strony. Jeśli strona niewidoczna nie generuje ruchu z fraz long-tail, nie pojawia się na pierwszej stronie wyników i nie jest w stanie zwiększyć widoczności strony poprzez treści eksperckie –to wyraźny sygnał alarmowy dla właściciela biznesu.

Przejmować się powinni także właściciele serwisów, którzy chcą poprawić widoczność strony, ale nie wiedzą, czy problem wynika z aspektów technicznych (np. mapa witryny, sitemap.xml, ładowanie strony, bezpieczeństwo witryny), czy z jakości treści (duplicate content, thin content, brak optymalizacji widoczności strony). Dla takich osób audyt SEO oraz analiza, jak Google ocenia stronę, są fundamentem do rozpoczęcia działań.

Kiedy tracisz w wynikach wyszukiwania strony? 10 najczęstszych powodów, przez które zmniejszasz widoczność swojej strony www

Strona najczęściej traci widoczność w momentach, w których jej struktura, jakość treści lub sygnały techniczne przestają odpowiadać wymaganiom algorytmów Google i — co istotne w 2025 roku — wymaganiom modeli AI. Widoczność strony internetowej spada po migracjach, wdrożeniach nowych wersji, aktualizacjach CMS czy zmianach w konfiguracjach, które mogą przypadkowo blokować indeksowanie strony. Roboty indeksujące Google reagują na każde zaburzenie techniczne: błędny plik robots.txt, uszkodzoną sitemap.xml, przekierowania pętli, wolne ładowanie strony czy utratę dostępności serwera.

Drugą grupą scenariuszy są problemy treściowe. Jeśli witryna zawiera zduplikowaną treść, thin content, chaotyczną strukturę lub elementy o niskiej jakości treści, spadki w wynikach wyszukiwania Google pojawiają się bardzo szybko. To jednak tylko część problemu. Modele AI — wykorzystywane przez Google do tworzenia AI Overviews – analizują treść strony internetowej pod kątem kompletności, eksperckości i przydatności. Jeżeli uznają, że treść jest mało wartościowa lub pozbawiona kontekstu, witryna może stać się stroną niewidoczną nawet wtedy, gdy jest poprawnie zaindeksowana. Oznacza to, że strona nie trafia do podsumowań AI, co znacząco obniża ruch z zapytań informacyjnych i long-tail.

Najbardziej widoczne spadki pojawiają się po większych zmianach algorytmicznych i w sytuacjach, w których Google na nowo ocenia autorytet domeny, strukturę informacji oraz zgodność treści z intencją użytkownika. Sygnałem ostrzegawczym są raporty Google Search Console pokazujące błędy indeksacji, zmniejszoną liczbę zaindeksowanych adresów URL, problemy z robotami Google lub komunikaty o niskiej jakości treści. Jeśli dodatkowo AI przestaje wykorzystywać Twoją stronę jako źródło informacji, utrata pozycji przyspiesza, a powrót na pierwszą stronę wyników staje się trudniejszy.

1. Meta tag „noindex” blokuje indeksowanie strony

To wciąż najczęstszy błąd techniczny, który sprawia, że strona nie wyświetla się w wyszukiwarce. Meta tag “noindex” wykorzystuje się go na przykład w trakcie budowy nowej witryny, kiedy nie zależy nam jeszcze, aby była ona wyszukiwana przez użytkowników.

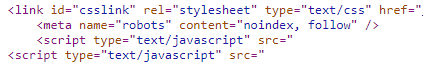

Jeśli więc stronę oznaczono:

<meta name="robots" content="noindex">– roboty indeksujące Google jej nie dodają do indeksu, a AI nie bierze jej pod uwagę w generowaniu odpowiedzi.

Zdarza się jednak, że znacznik „noindex” pojawia się w kodzie strony na skutek błędu. Dlatego jeśli nasza witryna „wypadła” z Google, zacznijmy od sprawdzenia wycinku kodu w kodzie źródłowym strony lub skorzystajmy z pomocy jednej z wielu wtyczek do przeglądarki np. “Meta Tag Checker”, aby upewnić się, że w kodzie nie ma znacznika „noindex”.

2. Blokada na poziomie serwera lub pliku robots.txt

1. Blokada w Pliku robots.txt

Plik robots.txt zarządza ruchem robotów Google i powinien znajdować się w głównym katalogu witryny (twojadomena.pl/robots.txt). Jest to jeden z najczęstszych powodów braku strony w indeksie Google.

- Całkowita blokada: Sprawdź, czy w pliku nie znajduje się dyrektywa:

User-agent: * Disallow: /

Taka konfiguracja całkowicie blokuje indeksowanie strony i uniemożliwia analizę treści robotom oraz AI.

- Brak pliku: Jeśli po wpisaniu ścieżki widzisz błąd 404, oznacza to, że plik

robots.txtnie istnieje. W takim wypadku brak indeksowania leży w innym miejscu. Warto go stworzyć, aby dać robotom pełne pozwolenie na dostęp:User-agent: * Allow: / - Wskazówka Google: Aby umożliwić robotom poprawne renderowanie i analizę strony, upewnij się, że udostępniasz im całą treść i nie wycinasz dostępu do zasobów CSS i JS. Unikaj także błędu 404 w tym pliku, ponieważ może to dezorientować roboty.

2. Blokada na poziomie serwera (.htaccess)

Blokada dla robotów wyszukiwarek może leżeć również po stronie konfiguracji serwera, najczęściej w pliku .htaccess. Aby sprawdzić tę możliwość, wystarczy otworzyć plik .htaccess i poszukać reguł blokujących. W celu weryfikacji można również posłużyć się narzędziem Google Search Console (GSC). Jeśli GSC jest w stanie pobrać i wyświetlić stronę, oznacza to, że problemu należy szukać poza blokadami serwera.

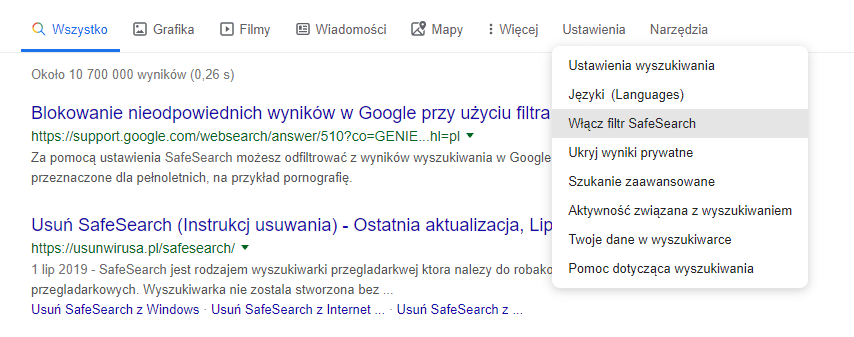

3. Filtr Safe Search

Jeśli Twoja strona zawiera treści przeznaczone tylko dla osób pełnoletnich, musisz sprawdzić, czy w wyszukiwarce Google nie jest włączony filtr SafeSearch. Włączenie tego filtra drastycznie obniża szansę na wyświetlanie Twojego serwisu w wynikach wyszukiwania. Wystarczy wyłączyć filtr, aby strona była znowu widoczna.

3. Nowa domena – Google i AI nie znają Twojej strony

Jeżeli korzystasz ze świeżo zakupionej domeny, na której dopiero opublikowałeś swoją stronę i nie kierują do niej żadne linki, istnieje duża szansa, że Google w ogóle nie wie o jej istnieniu!

Nowa strona internetowa często ma brak autorytetu, linków zwrotnych i pustą historię indeksowania. To powoduje, że roboty Google traktują ją jako mało wartościową, a AI Mode nie ma podstaw, aby cytować jej treści. Niestety Google nie jest (jeszcze) wszechmocny i warto trochę mu pomóc przy dotarciu do nowych stron.

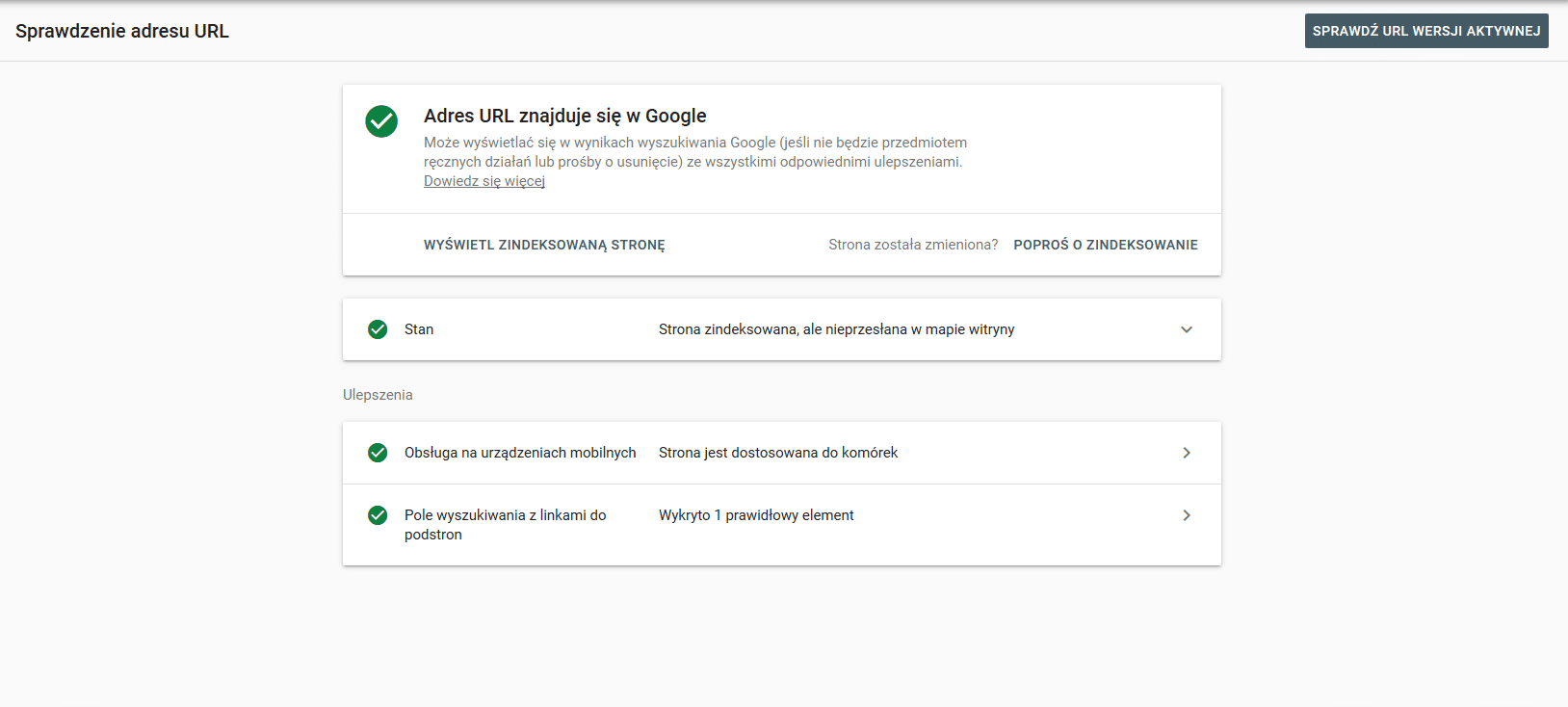

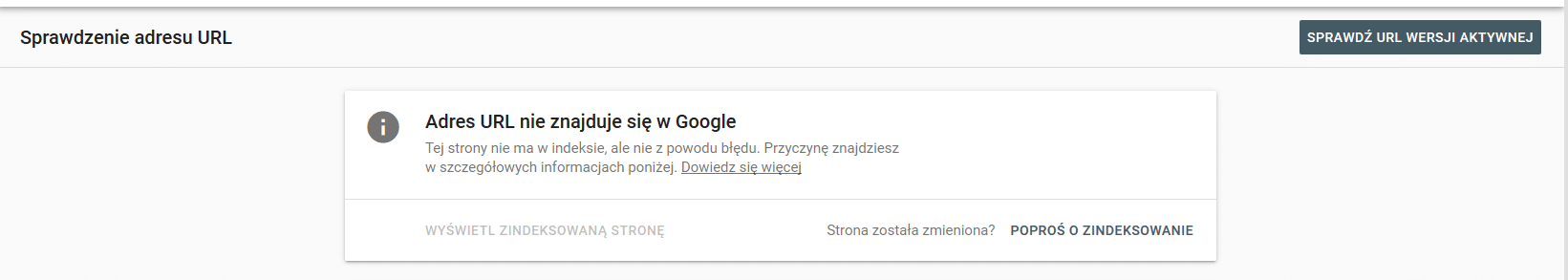

Sugeruję wówczas założyć konto w Google Search Console, zweryfikować własność domeny i poprosić Google o jej zaindeksowanie, a także przesłać mapę witryny (sitemap.xml). Prawdopodobnie już po kilku minutach zobaczysz efekt. Jeśli jednak to nie wystarczy, musisz liczyć się z tym, że aby indeksować nowe strony nie wystarczy już tylko spełniać warunków technicznych. Nowe domeny, zwłaszcza sklepy e-commerce, muszą dostarczać treści wysokiej jakości od pierwszego dnia — inaczej narzędzia AI mogą ich w ogóle nie uwzględnić w swoich podsumowaniach, przez co brak widoczności strony będzie utrzymywać się dłużej.

4. Problemy z bezpieczeństwem witryny

Sam brak wirusów i złośliwego oprogramowania może nie wystarczyć, ponieważ AI filtruje spam jeszcze precyzyjniej niż klasyczne algorytmy. Jeśli na stronie są niezabezpieczone formularze pozwalające na publikację komentarzy, może to wpłynąć negatywnie na indeksowanie witryny. Przykładowo, jeśli Twoją stronę znajdą spamboty, to możesz zostać potraktowany tak samo, jak właściciele zainfekowanych serwisów.

Google i modele AI bardzo cenią sobie transparentność i solidne zabezpieczenia. Jeśli pojawi się cień podejrzeń, że Twoja strona zawiera scam (oszustwo) lub spam, bardzo szybko spadniesz w rankingu. Co więcej, Google stale korzysta z modeli AI do wykrywania zagrożeń w czasie rzeczywistym. Jeśli AI oceni Twoją domenę jako mało wiarygodną z powodu nienaturalnego link buildingu, zduplikowanej treści lub innych nieuczciwych taktyk, widoczność może spaść, nawet jeśli w Google Search Console nie pojawiła się kara ręczna.

Wskazówka: Aby sprawdzić, czy na Twojej stronie występują oficjalnie wykryte problemy dotyczące bezpieczeństwa, zaloguj się do Google Search Console i sprawdź zakładkę „Problemy dotyczące bezpieczeństwa”.

5. Brak optymalizacji treści pod SEO

Każdemu właścicielowi strony www zależy, aby była ona wyświetlana na najwyższych pozycjach. Co jednak, jeżeli strona nie wyświetla się, nawet po wpisaniu frazy kluczowej złożonej z Twojego brandu i słowa na którym Ci zależy? Wtedy sprawdź swoje SEO!

Upewnij się czy:

- na Twojej stronie nie ma duplikatów treści,

- serwis jest zoptymalizowany zgodnie z wytycznymi google dla webmasterów,

- treści na stronie są naturalne, przydatne i odpowiadają na pytanie użytkownika

- masz poprawnie wprowadzony znacznik meta title.

Jeśli po spełnieniu tych warunków strona nadal nie wyświetla się w wynikach wyszukiwania, być może fraza jest trudna i mocno konkurencyjna. W takiej sytuacji zasięgnij porady specjalisty SEO.

6. Treść nie jest cytowana przez AI

Google ocenia stronę nie tylko algorytmami, ale również modelami AI, które generują gotowe odpowiedzi zamiast listy linków. Z tego względu roboty indeksujące Google analizują treść bardziej kontekstowo niż wcześniej. Jeśli treść strony internetowej jest uznana za thin content, ma niską jakość treści, zawiera duplicate content lub nie dostarcza wartości eksperckiej — nie tylko obniża to pozycje SEO, ale również zmniejsza szansę, że Twoja domena trafi do AI Overviews.

To w praktyce jeszcze bardziej obniża widoczność Twojej strony.

7. Ręczne działania i automatyczne filtry AI

W większości przypadków ręczne działania dotyczą prób manipulacji indeksem w wynikach wyszukiwania strony. Efektem tych niezgodnych z regulaminem działań webmasterów jest obniżenie pozycji strony albo wręcz jej niewyświetlenia.

Ręczne działania mogą dotyczyć:

- spamu tworzonego przez użytkowników (np. kwestia komentarzy wspomniana w poprzednim punkcie),

- problemów z danymi uporządkowanymi,

- nienaturalnych linków,

- niejawnych przekierowań,

- spamu,

- maskowania grafiki,

- ukrytego tekstu, lub upychania tekstu i słów kluczowych,

- niezgodności treści AMP.

Na szczęście ręczne działania w stosunku do swojej witryny możesz sprawdzić we wcześniej wspomnianej już Google Search Console, co pozwoli Ci podjąć odpowiednie działania w celu usunięcia problemu i cofnięcia kary.

Warto też dodać, że odkąd sztuczna inteligencja wpływa na widoczność strony internetowej, duża część „kar” nie wynika już z ręcznych działań, lecz automatycznych restrykcji nakładanych przez modele AI. Wiele filtrów działa automatycznie, a modele AI rozpoznają spam i manipulacje rankingiem, w dodatku słabe linki zwrotne mogą bardziej zaszkodzić niż pomóc. To wszystko powoduje, że jeśli treść na stronie jest nieprzydatna, system sztucznej inteligencji może ograniczyć jej ekspozycję bez informowania o tym w GSC.

8. Niepoprawny kod odpowiedzi HTTP

Każda z podstron przeznaczona do wyświetlania użytkownikom i umieszczeniu w rankingu Google powinna zwracać kod HTTP 200, czyli “OK”. Każdy z nagłówków HTTP ma swoją rolę i informuje o sposobie realizacji zapytania klienckiego.

Jeśli robot Google nie otrzyma od naszej strony poprawnego kodu może jej nie zaindeksować, a to uniemożliwi sztucznej inteligencji analizę i cytowanie treści. To, czy strona zwraca poprawny status HTTP możesz sprawdzić tutaj

9. Treści ukryte za logowaniem

Czy na Twojej stronie są treści lub podstrony wymagające zalogowania, do ich wyświetlenia użytkownikowi? A może cała domena jest chroniona hasłem? Roboty Google i AI nie logują się, nie przekraczają płatnych ścian i nie czytają treści dostępnych tylko dla wybranych. Ważne informacje za loginem oznaczają w tym przypadku stronę niewidoczną pod kątem SEO.

Treści dostępne wyłącznie dla zalogowanych użytkowników to problem, który często można przeoczyć, tym bardziej jeśli szukamy go samemu będąc zalogowanym użytkownikiem. Jak to łatwo sprawdzić? Wejdź w nowe okno incognito.

Aby otworzyć okno incognito w przeglądarce Chrome, możesz użyć skrótu klawiszowego: Windows, Linux lub Chrome OS: naciśnij Ctrl + Shift + N.

Korzystając ze sprzętu Apple, naciśnij ⌘ + Shift + N.

Jeśli używasz przeglądarki Firefox, zastosuj komendę: Ctrl + Shift + P.

Jako administrator strony widzisz więcej i masz dostęp do większej liczby funkcji niż przeciętny użytkownik lub robot. Jeśli na stronie są treści, a nawet całe podstrony wymagające zalogowania, lub cała domena chroniona jest hasłem – niezalogowany użytkownik, a więc także i robot wyszukiwarki, może do niej nie dotrzeć, przez co nie zostanie ona zindeksowana. Aby przekonać się, czy problem niewidoczności strony w wyszukiwarce tkwi właśnie w tym, najlepiej sprawdzić to korzystając z trybu incognito.

10. Problemy techniczne: prędkość ładowania, hosting, błędy JS

Problemy techniczne należą do najczęstszych i jednocześnie najbardziej niedocenianych przyczyn utraty widoczności strony internetowej. Jeżeli serwer działa niestabilnie, a ładowanie strony przekracza kilka sekund, roboty indeksujące Google ograniczają crawl budget, co prowadzi do niepełnego indeksowania strony i spadku pozycji w wynikach wyszukiwania Google. Kluczowe są tu opóźnienia po stronie hostingu, przeciążone serwery, błędy 503 oraz przerwy w dostępności, które utrudniają robotom Google dotarcie do zasobów. Każdy błąd na poziomie infrastruktury może w praktyce blokować indeksowanie strony, nawet jeśli pozostałe elementy techniczne są skonfigurowane poprawnie.

Drugą kategorią są błędy JavaScript — szczególnie na stronach SPA, w sklepach e-commerce oraz witrynach opartych na frameworkach JS. Jeśli kluczowe elementy treści renderują się dopiero po stronie klienta, a skrypty blokują inicjalne wczytanie DOM, modele AI i roboty wyszukiwarek mogą nie zobaczyć faktycznej zawartości. W efekcie treść strony nie jest odczytywana, część podstron znika z indeksu, a witryna przestaje pojawiać się na pierwszej stronie wyników. Co więcej — w 2025 roku problemy techniczne wpływają nie tylko na SEO. Modele AI, które oceniają jakość treści i jej strukturę, korzystają z zasobów dokładnie tak jak Googlebot. Jeśli skrypty uniemożliwiają dostęp lub powodują błędy, AI uznaje treść za nieczytelną, niepełną lub mało wartościową, co ogranicza jej szanse na cytowanie w AI Overviews.

Ostatnim elementem są nieprawidłowo działające komponenty strony: uszkodzone pliki JS i CSS, błędne przekierowania, niepoprawne statusy HTTP, brak optymalizacji obrazów oraz przestarzałe wtyczki. Każdy z tych czynników może zmniejszyć widoczność witryny, utrudnić optymalizację widoczności strony oraz negatywnie wpłynąć na proces indeksowania strony internetowej. Problemy te należy diagnozować w Google Search Console (raport Core Web Vitals, Crawl Stats) oraz narzędziach wydajnościowych, bo to one najczęściej wskazują rzeczywiste przyczyny utraty ruchu i jakości renderowania.

Jak przywrócić widoczność strony?

- Sprawdź blokady w robots.txt.

- Usuń meta tag „noindex”.

- Prześlij sitemap.xml w Google Search Console.

- Zoptymalizuj indeksowanie strony pod kluczowe kategorie.

- Wyczyść duplicate content.

- Dodaj eksperckie sekcje 5W1H.

- Uporządkuj linki zwrotne.

- Przeanalizuj widoczność w AI Overviews oraz trybie AI Mode.

- Dodaj sekcję FAQ.

- Zaktualizuj treści o dane i przykłady.

Podsumowanie

Strona może zniknąć z Google i z odpowiedzi AI nie tylko przez błędy techniczne, ale też przez sposób, w jaki algorytmy i modele AI oceniają jej treść oraz wiarygodność.

- Widoczność strony internetowej to dziś połączenie klasycznego SEO, poprawnego indeksowania oraz obecności w AI Overviews i trybie AI Mode.

- Strona niewidoczna w Google to często efekt problemów technicznych: meta tag „noindex”, błędny plik robots.txt, blokady na poziomie serwera, zły status HTTP czy wolne ładowanie strony.

- Modele AI mogą pomijać treść strony internetowej, jeśli uznają ją za thin content, duplicate content lub treści o niskiej jakości – nawet wtedy, gdy technicznie wszystko jest poprawne.

- Szczególnie narażone są nowe strony internetowe, sklepy online, serwisy w konkurencyjnych branżach i witryny z treściami ukrytymi za logowaniem lub słabo zabezpieczone.

- Sygnałem alarmowym są: spadek ruchu, brak widoczności na pierwszej stronie wyników, problemy z indeksowaniem strony w raportach Google Search Console oraz brak ruchu z fraz long-tail.

- Aby przywrócić widoczność strony, trzeba połączyć optymalizację techniczną (robots.txt, sitemap.xml, hosting, prędkość), poprawę jakości treści (EEAT, 5W1H, unikalność) oraz dbałość o wiarygodność domeny (linki zwrotne, bezpieczeństwo, brak spamu).

Źródła:

*https://www.searchenginejournal.com/study-google-ai-overviews-appear-in-47-of-search-results/535096/

** https://lp.botify.com/q4.2024-aio-report

Jak sprawdzić pozycje strony w Google, gdy wyniki zmienia AI?

Klasyczne narzędzia pokazują ranking tylko w organicznych SERP-ach. Aby realnie sprawdzić pozycje strony, analizuj Google Search Console, widoczność w AI Overviews oraz udział fraz long-tail. Warto też monitorować, czy Twoja treść jest cytowana w AI Mode – to dziś równie ważne jak obecność na pierwszej stronie wyników.

Czy mapa strony wpływa na szybsze indeksowanie nowych stron?

Tak. Poprawna mapa witryny i aktualny plik sitemap.xml pomagają robotom indeksować nowe strony oraz wskazują priorytety URL-i. Brak mapy lub jej błędna struktura może opóźniać indeksowanie i zmniejszać widoczność nowych podstron, zwłaszcza w serwisach e-commerce.

Czy link building nadal zwiększa widoczność strony w Google i AI?

Tak, ale liczy się jakość, nie ilość. Linki zwrotne z tematycznych, wiarygodnych domen budują autorytet Twojej strony i pomagają treści pojawiać się zarówno w wynikach wyszukiwania Google, jak i w AI Overviews. Słabe linki mogą natomiast obniżyć ranking.

Czy SEO lokalne może poprawić widoczność strony w Google?

SEO lokalne jest istotne dla firm obsługujących konkretne miasto lub region (sprawdź np. pozycjonowanie stron Gliwice). Optymalizacja wizytówki Google, lokalnych fraz oraz danych kontaktowych pomaga zwiększyć widoczność strony internetowej w wynikach lokalnych i poprawia jej autorytet w ocenie algorytmów.

Czy wolne ładowanie strony może blokować indeksowanie przez Google?

Tak. Spowolnienia serwera zwiększają czas renderowania, przez co roboty indeksujące Google pobierają mniej podstron. To ogranicza indeksowanie i obniża ranking. Optymalizacja prędkości ładowania jest jednym z głównych czynników technicznych poprawiających widoczność strony.

Czy brak linków zwrotnych może sprawić, że nowa strona będzie niewidoczna?

Tak. Nowa domena bez historii i linków zwrotnych ma niski autorytet, przez co Google może indeksować ją wolniej, a modele AI rzadziej cytują jej treści. Kilka jakościowych linków tematycznych może zdecydowanie przyspieszyć proces budowy widoczności.

Co zrobić, jeśli AI pomija treść mojej strony w podsumowaniach?

Najczęściej przyczyną jest niska jakość treści: thin content, brak kontekstu tekstu lub duplikaty treści. Rozszerz artykuły, dodaj dane liczbowe, sekcje FAQ i bardziej eksperckie akapity. AI cytuje treści kompletne, aktualne i dobrze ustrukturyzowane.

Dlaczego moja strona nie pojawia się na pierwszej stronie wyników, mimo że jest zaindeksowana?

Powodem najczęściej jest niski autorytet domeny, słabe linki zwrotne lub konkurencyjne frazy. Sprawdź ranking fraz w GSC, jakość treści i link building. Czasem konieczna jest również aktualizacja treści pod AI Overviews, aby zwiększyć widoczność strony.

Czy błędna mapa witryny może obniżyć widoczność strony?

Tak. Uszkodzone lub nieaktualne sitemap.xml utrudniają robotom Google analizę struktury serwisu. Może to ograniczyć indeksowanie strony internetowej i prowadzić do braków w widoczności kluczowych podstron. Regularna weryfikacja mapy jest obowiązkowa.

Jak autorytet strony wpływa na jej widoczność w Google i AI?

Im większy autorytet, tym częściej Google i AI wykorzystują Twoją treść jako źródło. Budujesz go poprzez jakościowy content, linki zwrotne i stabilną historię domeny. Strony o niskim autorytecie są pomijane w wynikach oraz w AI Overviews.

Wypełnij formularz

Przygotujemy dla Ciebie bezpłatną wycenę!

Dodatkowo otrzymasz bezpłatnie dostęp do kursów z marketingu internetowego.

Witam

moja strona to szmaragdowapracownia.pl – nie znam się zupełnie na tym i nikt nie jest w stanie mi wytłumaczyć dlaczego google jej nie otwiera i uznaje za niebezpieczną

Dzieńd dobry

Strona jest dostępna zarówno z protokołu http i https. Warto wykupić SSL i korzystać z wersji HTTPS, wtedy przeglądarki nie będą informować o potencjalnym zagrożeniu (domyślnie potrafią zmienić adres na taki z SSL).

Można też przekierować adresy z https na http przekierowaniem 301. W przypadku wdrożenia SSL przekierowanie również powinno istnieć tylko w drugą stronę :)

Odnośnie indeksowania, w site pierwsze strony są już widoczne, więc serwis zaczyna się indeksować. Niestety Google ostatnio ospale indeksuje nowe strony.

Pozdrawiam,

Piotrek Michalak