Czym jest crawl budget?

Zacznijmy od początku. Aby Twoja strona internetowa była widoczna w wyszukiwarce Google, najpierw musi zostać zaindeksowana. I nie chodzi tylko o stronę główną Twojego serwisu, ale każdą podstronę. Tak więc, im większy sklep internetowy prowadzisz i im więcej produktów sprzedajesz, tym większą uwagę musisz poświęcić crawl budget, czyli częstotliwości odwiedzin googlebota, który indeksuje strony. W tym tekście dowiesz się dokładnie, czym jest crawl budget i jakie warunki musi spełnić Twoja strona, aby był on jak najwyższy.

Czy wiesz, że roboty wyszukiwarek każdego dnia odwiedzają miliony stron, żeby zaindeksować zarówno nowe adresy, jak i szukać zmian na podstronach, które zapisały dawniej? Nieustanny wzrost ilości treści do zaindeksowania sprawił, że inżynierowie Google musieli zastanowić się, jak uczynić ten proces bardziej efektywnym. Nie podali jednak jednoznacznej definicji crawl budget. W dużym skrócie można powiedzieć, że budżet indeksowania określa częstotliwość odwiedzin googlebota na poszczególnych podstronach naszego serwisu. Wpływa na niego wiele czynników – na szczęście dzięki odpowiedniej optymalizacji możemy sprawić, by robot gładko przeszedł przez wszystkie adresy wewnątrz serwisu i poprawnie wyświetlił je później w wynikach wyszukiwania.

Podczas każdej wizyty robotów na stronie, wykorzystywane są zasoby zarówno serwera Google, jak i właściciela witryny. Aby nie obciążać nadmiernie infrastruktury obu stron, wprowadzono współczynnik indeksacji, określający możliwe zaangażowanie bota w witrynie. Gigant z Doliny Krzemowej opisał na swoim blogu czynniki, które brane są pod uwagę w czasie indeksacji. Wszystkie z nich zamykają się w dwóch pojęciach:

- crawl rate limit – limit współczynnika indeksacji, który określa liczbę połączeń, jakie robot może wykonać w obrębie witryny, by nie zakłócić jej funkcjonowania i doświadczeń użytkowników.

- crawl demand – częstotliwość indeksacji, określana na podstawie “popytu” danej witryny.

Crawl rate limit, czyli Google stara się być dobrym obywatelem Internetu

Czy jesteśmy skazani na odgórną decyzję Google, który określa, ile podstron może zaindeksować? Nie do końca. Istnieją czynniki, na które mamy wpływ, a które także decydują o wzroście lub spadku crawl budget. Są to:

- crawl health, określane na podstawie szybkości strony internetowej. Jeśli witryna wczytywana jest natychmiast i nie przeciąga czasu odpowiedzi, robot Google stwierdza, że może pozwolić sobie na zebranie informacji z pozostałych podstron. Jeśli natomiast strona wczytuje się wolno lub odsyła błędy, wówczas crawl rate limit maleje,

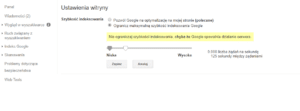

- limit szybkości indeksowania, który jesteśmy w stanie określić w Google Search Console. Jeżeli zauważymy, że robot zbytnio obciąża serwery naszej strony, możemy ograniczyć maksymalną szybkość indeksowania. Należy przy tym pamiętać, że zwiększenie limitu niekoniecznie zostanie zaakceptowane przez algorytm. Ta funkcja ma jedynie zapobiec problemom z nadmiernym wykorzystaniem zasobów. Warto też zauważyć, że panel, o którym mowa, jest dostępny jedynie w starszej wersji Search Console. W nowej natomiast nie znajdziemy już tej opcji.

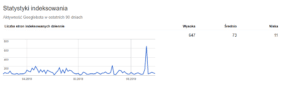

W starej wersji Google Search Console możemy również sprawdzić statystyki indeksowania, które dostarczą nam konkretnych danych o aktywności robotów w obrębie naszej witryny. Aby dostać się do tego widoku, należy w sekcji Skanowanie, wybrać opcję Statystyki indeksowania.

Naszym oczom ukażą się trzy wykresy, na podstawie których możemy prześledzić proces pracy googlebota. Uzyskamy tutaj między innymi informacje o liczbie podstron, które roboty każdego dnia odwiedzały na przestrzeni ostatnich miesięcy. Kolejne wykresy przedstawiają natomiast dane związane z czasem spędzonym przez roboty na stronie oraz liczbę pobranych dziennie kilobajtów.

Crawl demand, czyli popularność ma znaczenie

Zasada w tym przypadku jest bardzo prosta – crawl budget zwiększy się, jeżeli internauci chętnie odwiedzają witrynę, a dany adres URL generuje dużą liczbę wyświetleń. Potocznie nazywany popytem na indeksację, crawl demand jest istotnym czynnikiem behawioralnym, który wpływa na limit robotów Google. Zasoby crawlera będą w tym przypadku odpowiednio dostosowane, nawet jeśli strona jest dobrze zoptymalizowana, a pod względem czasu wczytywania strony nie będziemy mieli sobie niczego do zarzucenia.

Popularność witryny ma tutaj duże znaczenie – googlebot chętnie indeksuje strony, które są powszechnie znane i często odwiedzane przez rzesze użytkowników. Drugim istotnym czynnikiem jest aktualność informacji oraz częstotliwość aktualizacji podstron. Google pragnie serwować internatom najświeższe informacje z zaufanych źródeł – niechętnie będzie więc odwiedzać zapomniane strony internetowe, na których rzadko pojawiają się nowe treści.

Crawl budget – jak zachęcić roboty Google do odwiedzania naszej witryny?

Oprócz szybkości ładowania strony internetowej, na crawl budget wpłynąć mogą również inne czynniki optymalizacyjne. Aby zachęcić googleboty do indeksacji i nie marnować zasobów serwera, powinniśmy unikać:

- duplikatów treści – zarówno podstrony, których treść nie różni się zbytnio od siebie, jak i tzw. nawigacja fasetowa – czyli popularne w sklepach internetowych filtrowanie produktów, prowadzą do niepotrzebnej duplikacji treści w obrębie serwisu. Taki zabieg nie tylko negatywnie wpływa na crawl budget, ale też na ocenę całej strony w oczach Google. Innym powodem duplikacji treści są liczne podstrony tworzone dynamicznie na podstawie parametrów przesyłanych w adresie URL,

- miękkich błędów 404 – w przypadku, gdy podstrona – mimo, że nie istnieje – zwraca kod odpowiedzi 200 (zamiast 404), mówimy o tzw. miękkim błędzie 404,

- treści o niskiej jakości, thin content – indeksowanie podstron, na których znajduje się niewiele wartościowego tekstu, marnuje jedynie zasoby serwerów i ogranicza crawl budget. Treść na podstronach z thin content należy rozszerzyć lub zablokować przed indeksacją.

Podsumowanie – czy musisz przejmować się limitem indeksowania?

W zależności od tego, jak wielkim serwisem dysponujesz, crawl budget powinien mieć dla Ciebie większe lub mniejsze znaczenie. W przypadku małych stron, które zawierają od kilku do kilkudziesięciu podstron, limit indeksowania nie jest aż tak istotny, jak w przypadku olbrzymich sklepów internetowych. Duża liczba produktów lub też dynamicznie tworzone podstrony, np. na podstawie treści generowanych przez użytkowników, sprawiają, że przed robotem stoi ciężkie zadanie zaindeksowania wszystkich tych adresów. Aby mu to ułatwić i jednocześnie zapewnić sobie większą widoczność w wyszukiwarce, warto zatroszczyć się nie tylko o szybkość ładowania witryny, ale też pozostałe czynniki, o których wspominałem wcześniej. Pozbywając się niepotrzebnych duplikatów treści, podstron z thin content czy też miękkich błędów 404, mamy szansę na zwiększenie limitu indeksacji określonego przez algorytm.