Masz stronę www lub sklep internetowy, ale nie przynoszą one oczekiwanych zysków? Jeśli samodzielnie zajmujesz się promowaniem witryny, mogłeś nie zwrócić uwagi na istotne elementy. Możliwe, że przyjęta przez Ciebie strategia nie jest optymalna, a pozyskiwani klienci nie wpisują się w grupę docelową zainteresowaną Twoją ofertą. By zweryfikować obszary działań, niezbędna jest analiza strony internetowej, którą może wykonać agencja SEO lub niezależny specjalista. W poniższych punktach postaram się przybliżyć tajemnice pozycjonowania i zdradzę 10 kluczowych porad jak wykonać podstawowy audyt SEO.

Profil linkowy

Pierwszym krokiem jaki należy wykonać przy analizie strony jest weryfikacja jej profilu liniowego. W przypadku kiedy jest nienaturalny, to witryna może otrzymać ręczną lub algorytmiczną karę od Google, która spowoduje, że nasza witryna na dane słowa kluczowe będzie na odległych pozycjach wynikach wyszukiwania lub całkowicie zostanie z nich usunięta.

Audyt tego punktu należy zatem zacząć od sprawdzenia w narzędziach Google Search Console (dawnym Google Webmaster Tools) czy strona otrzymała karę ręczną. W przypadku złamania wytycznych wyszukiwarki Google otrzymamy powiadomienie o tym. Jeśli na Waszej witrynie nie ma zweryfikowanego narzędzia Google Search Console, to zachęcam do zapoznania z naszym poradnikiem, który wyjaśni od podstaw, czym jest GSC (Google Search Console), jak krok po kroku zainstalować je na serwisie, ale również pomoże opanować nawet amatorowi bez wiedzy technicznej wszystkie najważniejsze funkcjonalności tego narzędzia (Google Search Console).

W przypadku wykrycia kary, która może być nałożona z wielu różnych powodów, nie tylko za profil linkowy , należy podjąć działania prowadzące do jej zdjęcia. Jeżeli kara dotyczy nienaturalnych linków kierujących do naszej strony, to należy podjąć odpowiednie kroki w celu ich usunięcia. W wielu przypadkach może okazać się to niemożliwe, więc będziemy zmuszeni skorzystać ze zgłoszenia za pomocą Disavow Tool, które pomoże nam zrzec się odnośników naruszających wytyczne Google dla webmasterów.

Kolejnym elementem, który należy zweryfikować, jest ilość i jakość odnośników prowadzących do naszej strony. Możemy to zbadać, analizując dane z Google Search Console lub korzystając z zewnętrznych narzędzi takich jak płatny Ahrefs czy Majestic. Analizując profil należy zwrócić uwagę na:

- liczbę linków,

- liczbę domen linkujących,

- anchory (tekst zakotwiczenia stanowiący odnośnik),

- adres wskazywanej podstrony,

- jakość, użyteczność i tematyka serwisu, który linkuje do nas.

Niestety nie ma jednej, uniwersalnej reguły, która pozwoli określić jakość profilu liniowego każdej strony. Zawsze należy podchodzić indywidualnie do analizy danych, bo zupełnie inny profil linkowy będzie miała mała strona lokalnej firmy, dużego sklepu internetowego z tysiącami produktów i wielkiej korporacji działającej globalnie na całym świecie. Inną liczbę odnośników będzie miała witryna, która powstała kilka miesięcy temu i taka co działa 10 lat. Jeżeli mamy nową domenę i mały serwis, a liczba linków i domen będą liczone w setkach czy tysiącach, to powinno to wzbudzić nasze podejrzenie.

Twoja firma zasługuje na najlepsze miejsce w lokalnych wynikach Google. Zainwestuj w pozycjonowanie lokalne i przyciągnij nowych klientów już teraz!

Podobnie ma się sprawa z anchorami – inaczej będzie to wyglądało w przypadku dużych i małych stron, a także nowych i takich które istnieją kilka lat. Za nienaturalny rozkład tekstów zakotwiczenia można uznać taki, w którym większość linków jest nakierowany na frazy będące pozycjonowanymi słowami kluczowymi. Z reguły najczęściej linkowanym anchorami powinny być adresy url oraz nazwa firmy, choć ponownie nie jest to sztywna reguła.

Kolejny punkt, czyli adresy linkowanych podstron w przypadku dużych serwisów i sklepów powinien być mocno zróżnicowany. W końcu, jeśli na stronie www mamy setki tysięcy artykułów to użytkownicy będą publikować linki do różnych kategorii i produktów, stron bloga, FAQ, kontaktu czy wyników wyszukiwania w wewnętrznej wyszukiwarce. Jeżeli zatem taki serwis będzie miał linki wskazujące tylko stronę główną bądź wybrane kilka kategorii, to jest to sygnał, że może być coś nie tak.

Ostatnim krokiem tego etapu jest sprawdzenie jakości, użyteczności i tematyczności serwisów linkujących do naszej witryny. Wskazane jest odwiedzenie strony i ocenienie czy link został dodany naturalnie, np. w wątku na forum, gdzie użytkownicy doradzają sobie nawzajem w kwestiach związanych z naszą ofertą czy może odnośnik do naszej strony jest wstawiony w treści, która nie ma sensu i wygląda jak losowy zlepek słów niezwiązanych z tematyką podstrony, do której prowadzi.

Muszę jeszcze zaznaczyć, że żadne płatne, ani darmowe narzędzie nie pokazuje pełnego profilu liniowego domeny. Ahrefs, Majestic i podobne im narzędzia nie wskażą linków ze stron, które są zablokowane dla ich robotów, bądź nie zostały odwiedzone przez crawlera. Z kolei Google Serach Console pokazuje wyłącznie fragment profilu liniowego domeny, a nowe linki nie pojawiają się tam w czasie rzeczywistym (ich zaindeksowanie może zająć robotom Google nawet kilka tygodni). Dane pozyskane z tych narzędzi powinny jednak wystarczyć nam do wykonania audytu profilu liniowego i zaplanowania dalszych działań w tym zakresie.

Analiza i dobór słów kluczowych

Drugą ważną rzeczą podczas audytu strony jest weryfikacja słów kluczowych, które chcemy promować. Nieodpowiednio dobrane grupy fraz mogą być bardzo trudne do wypromowania na czołowe pozycje lub nie przynosić spodziewanego efektu – ich wysokie pozycje mogą nie przekładać się na ruch lub może on nie generować konwersji jakich oczekujemy. Weryfikację tego punktu powinniśmy zacząć od weryfikacji słów kluczowych, które pozycjonujemy i sprawdzeniu co najmniej pierwszej 10 wyników organicznych. Konkurencyjne serwisy analizujemy pod kątem ich tematyczności, zawartości związanej z pozycjonowanym wyrażeniem oraz typem witryny. Jeśli pozycjonujemy sklep internetowy, to konkurencyjne serwisy możemy weryfikować pod kątem tego, czy posiadają kategorię związaną z pozycjonowanym słowem kluczowym, ile mają w niej produktów, czy produkty są dobrze opisane, czy mają oceny i recenzje użytkowników, czy posiadają dodatkowe elementy powiązane z pozycjonowanym słowem kluczowym np. artykuły na blogu, strony informacyjne wyjaśniające, na co zwrócić uwagę wybierając produkt z danego działu, FAQ z odpowiedziami na najczęstsze pytania związane z promowaną frazą itp. oraz czy na pierwszej stronie występują lub przeważają konkurencyjne strony będące sklepami.

W przypadku, gdy większość konkurencji będą stanowiły strony innego typu lub agregatory ofert np. portale aukcyjne i ogłoszeniowe jak allegro.pl, olx.pl itp., a tylko jedna strona będzie typowym sklepem, może to oznaczać, że wypracowanie pozycji naszej witryny w top 10 będzie trudniejsze i wymagać będzie dużego nakładu prac oraz rozbudzonego serwisu. Prace takie mogą potrwać wiele miesięcy, a nawet lat, a pozycja będzie umacniać się bardzo wolno, więc może to się okazać nieopłacalne, ponieważ zanim słowo kluczowe zacznie przekładać się na zysk, czyli np. generować co miesiąc zauważalną liczbę odwiedzin będzie konieczna bardzo duża inwestycja czasu i praw podobnie kosztowanych działań. W takich przypadkach znacznie lepiej jest wybrać inne wyrażenia do promowania np. bardziej doprecyzowane, a nawet z długiego ogona (tzw. long tail), na które na pierwszej stronie wyników Google będą pojawiały się głównie strony podobne do naszej, a konkurencje stanowią mniejsze serwisy.

Jeśli serwis nie osiąga żadnych pozycji pomimo naszych działań, to bardzo możliwe, że dobrane słowa kluczowe mogą być zbyt konkurencyjne. W takim przypadku najlepszym wyjściem jest dobór mniej konkurencyjnych wyrażeń, dla których w krótszym czasie powinno nam się udać wypracować zadowalające pozycje. Dobre wyniki dla licznych haseł powinny wpłynąć na zwiększenie ruchu, a ten przełożyć się na wzrost zainteresowania naszą ofertą. Dodatkowo promowanie słów doprecyzowanych, a nawet long tail pomaga również w wypromowaniu wyrażeń bardziej ogólnych i chętniej wyszukiwanych.

Dobór linkowanych podstron

Po analizie słów kluczowych i odrzuceniu tych, które nie przyniosą aktualnie oczekiwanego zysku i doborze fraz, które pomogą ściągnąć na naszą witrynę potencjalnych klientów, powinniśmy sprawdzić, czy prawidłowo ustaliliśmy podstrony docelowo promowane. Jest to bardzo ważny punkt audytu, ponieważ jeśli źle wybierzemy podstronę, którą będziemy promowali na dane słowo kluczowe, to osiągniemy znacznie gorsze wyniki niż w przypadku prawidłowego wyboru. Jak się do tego zabrać? W najprostszy z możliwych sposobów – musimy sprawdzić jakiego rodzaju strony preferuje Google poprzez wpisanie w wyszukiwarce po kolei każdej z promowanych fraz. Weryfikując wyniki wyszukiwania, należy zwracać uwagę jakiego typu strony się w nich znajdują, dla przykładu: czy są to artykuły, strony kategorii, produkty, sklepy, serwisy aukcyjne, małe strony firmowe, fora itp.

Jeżeli nazwy domen na pierwszej stronie wyników nic nam nie mówią, to należy odwiedzić każdą z nich i na szybko zapoznać się z każdą witryną. Na linkowaną podstronę warto wybrać w naszym serwisie stronę podobną do konkurencji zajmującej czołowe pozycje. Jeśli zatem w top 10 znajdują się wyłącznie strony kategorii z produktami, to warto również spróbować wypromować podobny dział w naszej witrynie. W przypadku, gdy nasza strona jest zupełnie inna niż serwisy z czołowych pozycji, warto rozważyć rozbudowę lub zmianę pozycjonowanych słów kluczowych. Kiedy zależy nam na szybkim pozyskaniu klientów z tego typu fraz, należy również rozważyć opcję promowania witryny w Google Ads.

Przekierowania

Mając już zweryfikowany profil linkowy, wybrane słowa kluczowe oraz dobrane promowane strony, możemy zacząć techniczny audyt witryny internetowej. Zaczynamy go od prostej weryfikacji, czy strona posiada przekierowania na jedną wersję adresu. Dla robotów Google strona działająca pod adresem z www (np. www.nazwadomeny.pl) i bez www (np. nazwadomeny.pl) to dwa różne serwisy. Jeśli nie posiadamy wdrożonego przekierowania, to będziemy posiadali dwa różne adresy tej samej witryny. Tego typy duplikat może negatywnie wpłynie na widoczność serwisu.

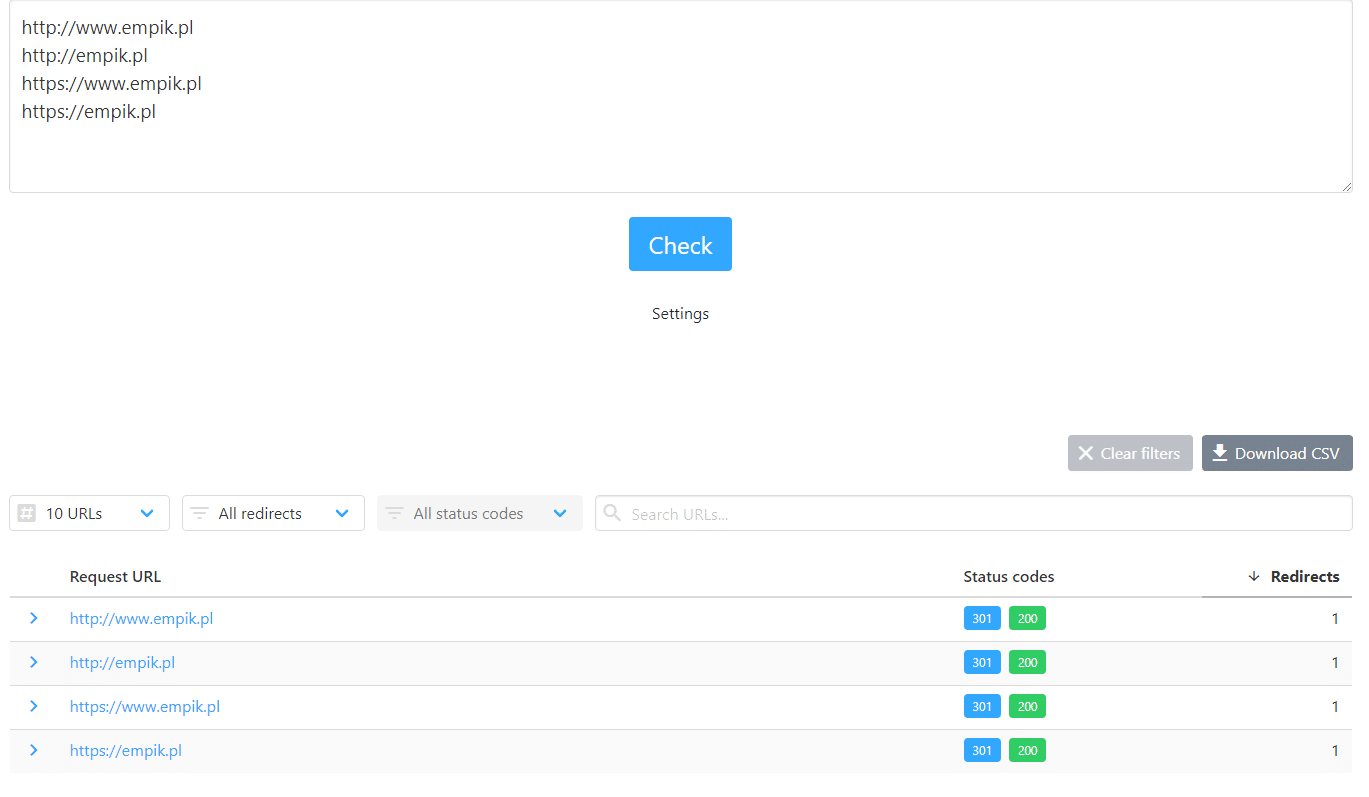

To, czy mamy przekierowanie możemy zweryfikować bardzo prosto i nie potrzebujemy do tego żadnych płatnych narzędzi. Wystarczy w przeglądarce wpisać różne wersje adresu promowanej domeny – z przedrostkiem www i bez tego przedrostka. Jeśli niezależnie od wpisanej wersji adresu będzie nam się wyświetlała jedna wersja adresu, to znaczy, że przekierowanie jest wdrożone. W takim przypadku warto jeszcze sprawdzić typ przekierowania. Powinno ono być przekierowaniem stałym z nagłówkiem HTTP 301. Rodzaj przekierowania można sprawdzić za pomocą darmowego narzędzia takiego jak np. https://httpstatus.io/

Weryfikując rodzaj przekierowania, warto również sprawdzić czy nasz serwis posiada również przekierowanie wersji z lub na wersję HTTPS. Jeśli w kolumnie Status codes pojawią się wyłącznie kody 200, oznacza to, że nie posiadamy przekierowania i powinniśmy je czym prędzej wdrożyć. W przypadku gdy wyświetli się Error, oznacza to błąd przy próbie weryfikacji. Taki komunikat może się pojawić jeśli np. nie posiadamy wersji z certyfikatem SSL, a próbujemy zweryfikować jej status. W takim przypadku nie należy się tym przejmować. Jeśli jednak wspomniany błąd pojawia się przy wersji adresu z HTTP, może to oznaczać, że domena została źle skonfigurowana. W takiej sytuacji warto skonsultować się z administratorem strony lub hostingiem, na którym mamy skierowaną domenę. W przypadku gdy posiadamy przekierowanie, ale jako status jest podany kod 302 lub inny 3xx (oprócz 301) oznacza to, że powinniśmy zmienić przekierowanie na stałe. Najlepiej o taką zmianę poprosić administratora opiekującego się stroną lub agencję SEO.

W przypadku gdy na stronie nie mamy takiego przekierowania to wcale nie znaczy, że Google będzie indeksowało wszystkie możliwe wersje adresu domeny. Warto w takiej sytuacji zweryfikować czy w kodzie strony, a dokładniej w sekcji head, znajduje się znacznik canonical wskazujący odpowiednią wersję adresu. Możemy to zweryfikować otwierając w przeglądarce wszystkie wersje strony (HTTP z www, bez www, HTTPS z www, bez www) i wyświetlając ich kod źródłowy (w Google Chrome można to zrobić klikając prawym przyciskiem myszy i wybierając Wyświetl źródło strony lub za pomocą klawiszy CTRL+U). W kodzie powinniśmy poszukać znacznika canonical, który może mieć poniższą postać:

<meta name="canonical" href="https://www.nazwadomey.pl/" />

Wartość parametru href w powyższym znaczniku, dla każdej wersji strony, powinna mieć taką samą postać. Jeżeli wszystkie wersje adresu mają inną formę domeny oznacza to, że należy ją ujednolicić.

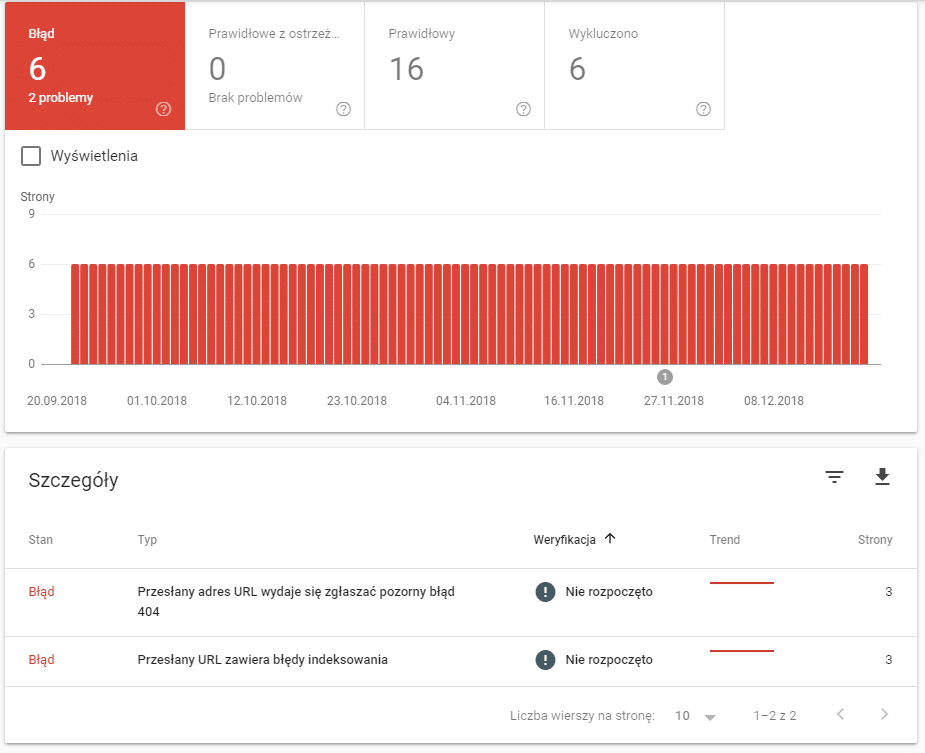

Jedną z ostatnich rzeczy z tego punktu, jaką powinniśmy sprawdzić jest weryfikacja czy serwis posiada podstrony zwracające nagłówek 404. Jeśli mamy zainstalowane narzędzia Google Search Console, to można zweryfikować to w łatwy sposób za ich pomocą. Wystarczy przejść do w sekcji Indeks do zakładki Stan i tam znajdziemy informacje na temat błędów 404 i innych problemów wykrytych przez Google na naszej stronie.

Po wybraniu występującego błędu zostaną wyświetlone szczegółowe informacje na jego temat wraz z adresem URL, którego dotyczy. Jeśli wskazane jako błędne podstrony są nieprawidłowymi adresami, najlepszym wyjściem jest przekierowanie ich za pomocą przekierowania 301 na ich prawidłowe wersje lub pokrewne podstrony. W przypadku, gdy URLe nie posiadają swoich odpowiedników ani powiązanych działów, w ostateczności możemy przekierować je na stronę główną lub ogólną stronę oferty.

Z uwagi, że nieprawidłowo wprowadzone przekierowanie lub znaczniki canonical mogą utrudnić prawidłowe indeksowanie strony robotom wyszukiwarek, to w przypadku wykrycia braku przekierowania najlepiej zlecić jego wykonanie doświadczonej osobie, agencji SEO bądź informatykowi, który będzie posiadał wiedzę z zakresu wykonywania przekierowań i wprowadzania zmian w znacznikach dla robotów wyszukiwarek.

Sekcja head

Jest to jedna z ważniejszych części dokumentu HTML, a znaczniki tam umieszczone są oceniane przez Google. Większość osób, które nie mają doświadczenia w pozycjonowaniu, kojarzy tę sekcję ze znacznikiem meta keywords, w którym uzupełniają słowa kluczowe, na które docelowo ma rankingować serwis. Niestety Google od wielu lat nie bierze pod uwagę tego znacznika, więc jego uzupełnienie nie jest konieczne. Podczas audytu sekcji head (kodu źródłowego strony znajdującego się między znacznikami <head> i </head>) należy zwrócić przede wszystkim uwagę na tytuł (znacznik <title>, opis strony (znacznik <meta name=”description” content=”” />) i znacznik robots (<meta name=”robots” content=”” />).

Tytuły

Znacznik title powinien być unikalny dla każdej podstrony serwisu, krótko informować użytkownika co znajduje się na danej podstronie i mieć długość około 60 – 80 znaków. W przypadku kiedy tytuł będzie dłuższy, Google wyświetli w wynikach wyszukiwania po prostu jego część. Bardzo często będzie to fragment, który zawiera szukane przez użytkownika wyrażenie. Ważne, aby umieścić w nim najważniejsze frazy kluczowe promowane na daną podstronę.

Opis strony

Podobnie jak tytuł, również ten znacznik powinien być unikalny dla każdej podstrony serwisu, a jego zalecana długość powinna wynosić około 150 znaków. W znaczniku meta description warto umieścić tekst zawierający słowa kluczowe, które docelowo chcemy promować. Jeśli opis będzie dłuższy, to Google, tak samo jak w przypadku tytułu, samodzielnie wybierze fragment opisu, który pokaże użytkownikowi w wynikach wyszukiwania. Tworząc opis strony należy zadbać o to, aby zachęcał on użytkowników do odwiedzenia naszego serwisu. Warto zatem zadbać o elementy CTA (ang. call to action) skłaniające użytkowników do kliknięcia i odwiedzenia naszej strony.

Robots

Kolejnym bardzo ważnym znacznikiem znajdującym się w sekcji head jest meta tag robots. Określa on m.in. czy roboty wyszukiwarek mają indeksować daną podstronę i czy umieszczone na niej linki wychodzące mają przekazywać wartość PageRank. Warto zweryfikować czy strony, które chcemy promować nie są przypadkiem zablokowane przed indeksowaniem dla robotów. Znacznik ten może mieć wiele różnych wartości, ale najczęściej spotykaną formą, która pozwala na indeksowanie jest:

<meta name="robots" content="index, follow" />

Jeśli ten meta tag będzie posiadał w parametrze content wartość noindex lub none, oznacza to, że dany URL jest zablokowany przed indeksowaniem. W takiej sytuacji należy zmodyfikować jego zawartość w przypadku, kiedy strona jest wartościowa i chcemy, aby pojawiała się w wynikach wyszukiwania.

Jeśli w kodzie strony nie znajdziemy meta tagu robots, to znaczy, że dana podstrona powinna być indeksowana normalnie. W przypadku braku znacznika roboty wyszukiwarek traktują stronę tak jakby miała meta tag o wartości index, follow.

Dodatkowe informacje na temat meta tagów można znaleźć w poradach Google dla webmasterów:

https://support.google.com/webmasters/answer/79812?hl=pl

https://support.google.com/webmasters/answer/35624?visit_id=636804966072331314-2221896487&rd=1

Ustawienie wartości tagów w sekcji head wydaje się prostą czynnością, ale osoby bez doświadczenia w pozycjonowaniu mogą mieć problem z prawidłowym konstruowaniem tytułów i meta opisów strony w taki sposób, aby zarówno zachęcały użytkowników do odwiedzenia strony jak również były tematyczne dla robotów wyszukiwarek. Z kolei nieprawidłowa konfiguracja znacznika robots może spowodować wyindeksowanie naszej strony (oznacza to całkowite usunięcie z wyników wyszukiwarek pojedynczej podstrony lub w skrajnych przypadkach usunięcie całego serwisu) bądź indeksację małowartościowych podstron. Dobrym pomysłem będzie zatem powierzenie tego zadania osobie z doświadczeniem w optymalizacji SEO.

Nawigacja

Następną częścią strony, którą należy dokładnie przeanalizować jest nawigacja. Powinna być ona przede wszystkim czytelna i łatwa w obsłudze dla użytkownika. Warto zatem zwrócić uwagę, by nazwy linków w menu dobrze określały podstrony, do których kierują, ale także aby zawierały słowa kluczowe, które są pozycjonowane. Najlepiej stosować najbardziej ogólne frazy, tak by nazwa była krótka i jasno informowała roboty wyszukiwarek i użytkowników co znajdą na podstronie, do której prowadzi link. Przykłady prawidłowych nazw odnośników do kategorii krzeseł drewnianych z wieloma rodzajami mebli:

- Krzesła drewniane,

- krzesła,

- krzesła do kuchni,

- itp.

Przykłady nieprawidłowych nazw odnośników:

- Tanie krzesła drewniane z drewna, dębowe, sosnowe, olchowe, nowe, markowe, luksusowe – nazwa jest zbyt długa i zawiera bardzo dużo słów kluczowych, w tym również takie, które z reguły się wykluczają np. tanie i luksusowe,

- Białe krzesła drewniane – zbyt zawężona nazwa, użytkownicy, którzy będą szukali czarnych czy innych niż białe krzeseł nie klikną w ten link, mimo, że w kategorii jest wiele rodzajów produktów,

- Krzesła – zbyt ogólne wyrażenie nie precyzuje, że znajdują się tu tylko krzesła drewniane, roboty Google będą uznawały kategorię za mniej związaną tematycznie z krzesłami drewnianymi.

Wszystkie ważne podstrony powinny być dostępne w głównej nawigacji. Najlepiej zatem będzie jeśli, niezależnie od tego na jakiej podstronie witryny jest użytkownik, za pomocą jednego kliknięcia mógł przejść do głównych podstron w serwisie. Oznacza to, że jeżeli jest to możliwe, to w menu na całym serwisie powinny być odnośniki do najważniejszych i zarazem głównych promowanych podstron. Dobrą praktyką będzie jeśli do odwiedzenia dowolnej innej podstrony wystarczą użytkownikowi maksymalnie kilka kliknięcia. W przypadku, gdy tych kliknięć jest sporo więcej, użytkownik może nie dotrzeć do tego czego szukał i opuścić nasz serwis.

Na sklepach i stronach posiadających skomplikowaną strukturę z podkategoriami, zalecana jest również dodatkowa nawigacja okruszkowa (tzw. breadcrumb). Pomaga ona robotom wyszukiwarek i użytkownikom w szybkim zorientowaniu się w aktualnej lokalizacji i łatwe przechodzenie do nadrzędnych działów. Odnośniki w breadcrumbie powinny mieć tworzone nazwy w sposób podobny do tradycyjnego menu – warto by zawierały najbardziej ogólne słowa kluczowe.

Analiza strony powinna również zweryfikować, czy posiada ona przyjazne linki i czy są w nich stosowane słowa kluczowe. Dobrym przykładem przyjaznego linka jest odwzorowanie w nim struktury strony w nawigacji. Przykładowo model krzesła XYZ, który znajduje się w kategorii Meble -> Krzesła -> Krzesła drewniane -> Tapicerowane może mieć przyjaznego linka w postaci:

/meble/krzesla/krzesla-drewniane/tapicerowane/krzeslo-xyz

W przyjaznych linkach lepiej unikać używania polskich liter oraz znaków, które nie występują w angielskim alfabecie. Warto również stosować jednolite nazewnictwo i całe adresy zapisywać z małej litery oraz zamiast odstępów pomiędzy słowami stosować znak myślnika. W przypadku, gdy nasza strona posiada adresy typu:

/index.php?kat=12345&podkat=14&podkat2=5&prod=6821&sort=1a&lang=1

należy zadbać o ich zmianę na przyjazne. Jeśli jednak nie posiadamy zaawansowanej wiedzy związanej z tworzeniem stron, a panel administracyjny nie ma opcji włączenia takich przyjaznych adresów, będziemy zmuszeni zlecić wykonanie takiej zmiany twórcy naszej strony, specjaliście bądź agencji SEO.

Dalszym krokiem naszej analizy będzie weryfikacja typu linków użytych w nawigacji. Można go sprawdzić w kodzie źródłowym strony. Odnośniki do stron, które promujemy i pozostałych podstron serwisu, takich jak kategorie, strony informacyjne, artykuły, strona kontaktowa, produkty itp. nie powinny mieć w linku parametru rel=”nofollow”. Parametr taki może znajdować się wyłącznie na odnośnikach do podstron o niskiej wartości dla robotów Google (np. linki do strony z koszykiem, zmianą hasła, polityką plików cookies itp.), czy linków wychodzących do innych domen (np. linków sponsorowanych)Jeżeli odnośniki prowadzące do podstron, które chcemy promować posiadają taki parametr, to należy go usunąć.

Jedną z ostatnich kwestii jaką należy zweryfikować podczas analizy nawigacji jest to, czy na stronie nie ma odnośników wskazujących podstrony błędu 404. Sprawdzić należy zarówno błędy w wewnętrznym linkowaniu jak również odnośniki do zewnętrznych serwisów. W przypadku gdy posiadamy małą stronę, złożoną z kilku podstron, audyt tego elementu możemy wykonać ręcznie sprawdzając każdy odnośnik na stronie. Jeżeli natomiast nasza strona składa się z kilkudziesięciu podstron lub więcej, to lepiej skorzystać z jednego z wielu narzędzi SEO, badających nagłówki zwracane przez odnośniki. Jeżeli wykryjemy linki prowadzące do stron 404 musimy je zaktualizować tak, aby prowadziły na prawidłowe URL lub usunąć.

Treści

Następną bardzo ważną częścią strony jaką musimy sprawdzić są treści – obecność i optymalizację pod kątem SEO. Teksty powinny być użyteczne dla użytkowników i przedstawione w takiej formie, która zachęci ich do zapoznania się z nimi. Konieczne jest również umieszczenie w nich promowanych przez nas słów kluczowych, które pomogą w zbudowaniu tematyczności strony. Optymalizując opisy warto po raz kolejny przejrzeć strony z top 10 i zobaczyć jakie informacje znajdują się na serwisach konkurencji. Weryfikujemy jakimi słowami kluczowymi są one nasycone, jakich kolokacji i synonimów używają, oraz jaką mają długość. Jeśli wiadomości na naszej stronie znacznie odbiegają od średniej, to powinniśmy pomyśleć o rozbudowaniu opisów. Dodając teksty na stronie należy zastanowić się czego może szukać użytkownik, jakie wiadomości go zainteresują i skłonią do pozostania na serwisie. Jeśli nie mamy lekkiego pióra, warto poszukać copywritera, który wspomoże nas w rozbudowie witryny.

Ważne jest również zadbanie o prezentację użytkownikowi naszych opisów w taki sposób, by zachęcić go do zapoznania się z nimi. Należy unikać długiego i zbitego w jeden akapit tekstu. Treść warto urozmaicać wytłuszczeniem czcionki, nagłówkami, umieszczać w nich zdjęcia czy infografiki oraz inne elementy przyciągające wzrok odwiedzających.

Skoro już wspomnieliśmy o nagłówkach, to podczas audytu również powinniśmy przeanalizować ten element strony. Warto zacząć od tego czy promowane przez nas podstrony i strona główna posiadają nagłówek pierwszego poziomu – h1 i czy zawiera on słowa kluczowe. Dobrze jeśli w nagłówku h1 znajdują się przynajmniej te najbardziej konkurencyjne wyrażenia, które określają tematyczność danej strony. Jeśli już zweryfikujemy nagłówki pod tym kątem, to warto również sprawdzić czy nie ma ich na stronie zbyt wielu lub czy nie zostały umieszczone na elementach, które nie są ważne. Przykładami takich nadmiarowych nagłówków mogą być:

- globalny nagłówek h1 na logo serwisu,

- nagłówki hx np. h1 – h6 na wszystkich odnośnikach w menu,

- nagłówki hx na wielu elementach stopki

W przypadku wykrycia nadmiarowych nagłówków hx najlepszym rozwiązaniem będzie ich zmiana na inne elementy blokowe z zachowaniem wyglądu, które miał dany nagłówek. Jeśli nie mamy wiedzy z zakresu front-endu, do wdrożenia tego rozwiązania może być konieczna pomoc webmastera.

Analizując treści koniecznie należy je sprawdzić również pod kątem duplikatów z innych stron. Warto to zrobić nawet jeśli tworzyliśmy je samodzielnie, ponieważ właściciel innej strony mógł skopiować nasze opisy i wstawić je na swojej witrynie. Jedną z najłatwiejszych metod weryfikacji tekstów pod kątem unikalności jest kopiowanie po 2 – 3 zdania i wklejanie w wyszukiwarce Google. W przypadku, gdy na wyszukiwany fragment nasza witryna pojawia się na dalszych pozycjach, należy zweryfikować serwisy, które posiadają zbliżony tekst lub jego kopię. W sytuacji, gdy inna strona skopiowała nasze teksty, warto spróbować skontaktować się z jej właścicielem, poinformować go o naruszeniu praw autorskich i poprosić o usunięcie. Jeśli to nie pomoże to najszybszym wyjściem będzie przeredagowanie opisów, tak aby były całkowicie unikalne.

Kwestią, na którą trzeba również zwrócić uwagę to umiejscowienie opisów na stronie. Warto zadbać, by choć część opisu znalazła się w tzw. polu ATF (ang. above the fold), czyli widocznym od razu po załadowaniu się strony bez przewijania strony scrollem. Może to być jeden z czynników rankingowych dla Twojej branży, a dodatkowo opisy w obszarze ATF pomagają użytkownikowi w szybkiej ocenie przydatności strony. Jeżeli nasze opisy znajdują się na samym dole i użytkownik musi przewinąć dużą część strony, by do nich dotrzeć, konieczne będzie zmodyfikowanie wyglądu witryny i przesunięcie tekstów na górę.

Grafiki

Często ignorowana przez wielu właścicieli stron jest optymalizacja grafik na stronie. Robiąc audyt SEO strony internetowej nie należy pomijać tego ważnego elementu serwisu. Powinniśmy sprawdzić go pod kątem kilku kwestii.

Jakość i waga

Złą praktyką jest umieszczanie bardzo dużych zdjęć i wyświetlanie ich na stronie w mniejszym rozmiarze. Jeśli na naszej stronie część grafik ładuje się bardzo wolno, to koniecznie należy zweryfikować czy możemy je zmniejszyć lub zastosować większą kompresję. Stosowane przez dużą część webmasterów formaty po kompresji prezentują się niemal tak samo dobrze jak przed kompresją. Przeciętny użytkownik nie zauważy utraty jakości, ale zauważalnie odczuje znacznie szybsze ładowanie strony. Prędkość działania jest również jednym z czynników branych pod uwagę przez algorytm Google podczas ustalania rankingu w wyszukiwarce.

Atrybut alt

Mając pewność, że wszystkie grafiki są odpowiednich rozmiarów i wystarczającej jakości, należy zweryfikować wartość atrybutu alt. Alt jest alternatywnym tekstem, który pojawi się użytkownikowi w przypadku, gdy nie załaduje się grafika. Zawartość tego atrybutu wykorzystują również osoby niewidome i niedowidzące oraz przeglądarki tekstowe jak Lynx. Warto zatem zadbać, by dokładnie i krótko opisywały zawartość grafiki. Do parametru alt warto również dodać słowo kluczowe, o ile ma związek z grafiką.

Następnym elementem jaki powinniśmy sprawdzić na obrazkach są nazwy i ścieżki plików. Jeśli to możliwe, warto zadbać o to, aby nazwa pliku oraz ścieżka do niego były przyjazne, a nazwa może dodatkowo zawierać skrócony opis grafiki. Pomoże to robotom Google na powiązanie zdjęcia z tematyką serwisu, a dla użytkowników będzie to znacznie czytelniejsze niż nic nie mówiące nazwy i ścieżki.

Przykład prawidłowej ścieżki i nazwy nasyconej słowami kluczowymi:

/zdjecia/krzeslo-drewniane-tapicerowane-dab-xyz.jpg

Przykład ścieżki i nazwy pozbawionych optymalizacji pod frazy:

/include/uploads/img/c1231/s923/dsc_12039_113.jpg

Patrząc na pierwszą ścieżkę grafiki od razu domyślamy się co może ona zawierać, natomiast zerkając na drugą nie jesteśmy w stanie tego określić. Po zastosowaniu prawidłowej wersji nazw plików i ścieżek na serwerze, w których się one znajdują również robotom Google i innych wyszukiwarek będzie łatwiej określić zawartość fotografii.

Podpisy i otaczające treści

Kwestią pomijaną przez wielu właścicieli stron są podpisy pod zdjęciami. Warto je stosować, ponieważ informują one użytkowników co znajduje się na grafice, a dodatkowo są elementem wykorzystywanym w niektórych branżach do nasycenia treści strony najważniejszymi słowami. Tworząc opisy należy zadbać o to, by każdy podpis pod grafiką był unikalny – nie należy kopiować jednego opisu wielokrotnie pod różnymi zdjęciami.

Mapa zasobów

Elementem o jaki warto zadbać, a czasami pomijanym, jest utworzenie mapy XML zawierającej adresy obrazków z naszej strony i zgłoszenie ich za pomocą Search Console. W przypadku, gdy część zdjęć nie została zaindeksowana przez Google, działanie takie może pomóc w ich indeksacji.

Więcej informacji na temat optymalizacji obrazków, w tym również pod wyszukiwarkę grafik Google można znaleźć na naszym blogu we wpisie Pozycjonowanie grafiki w wyszukiwarce Google.

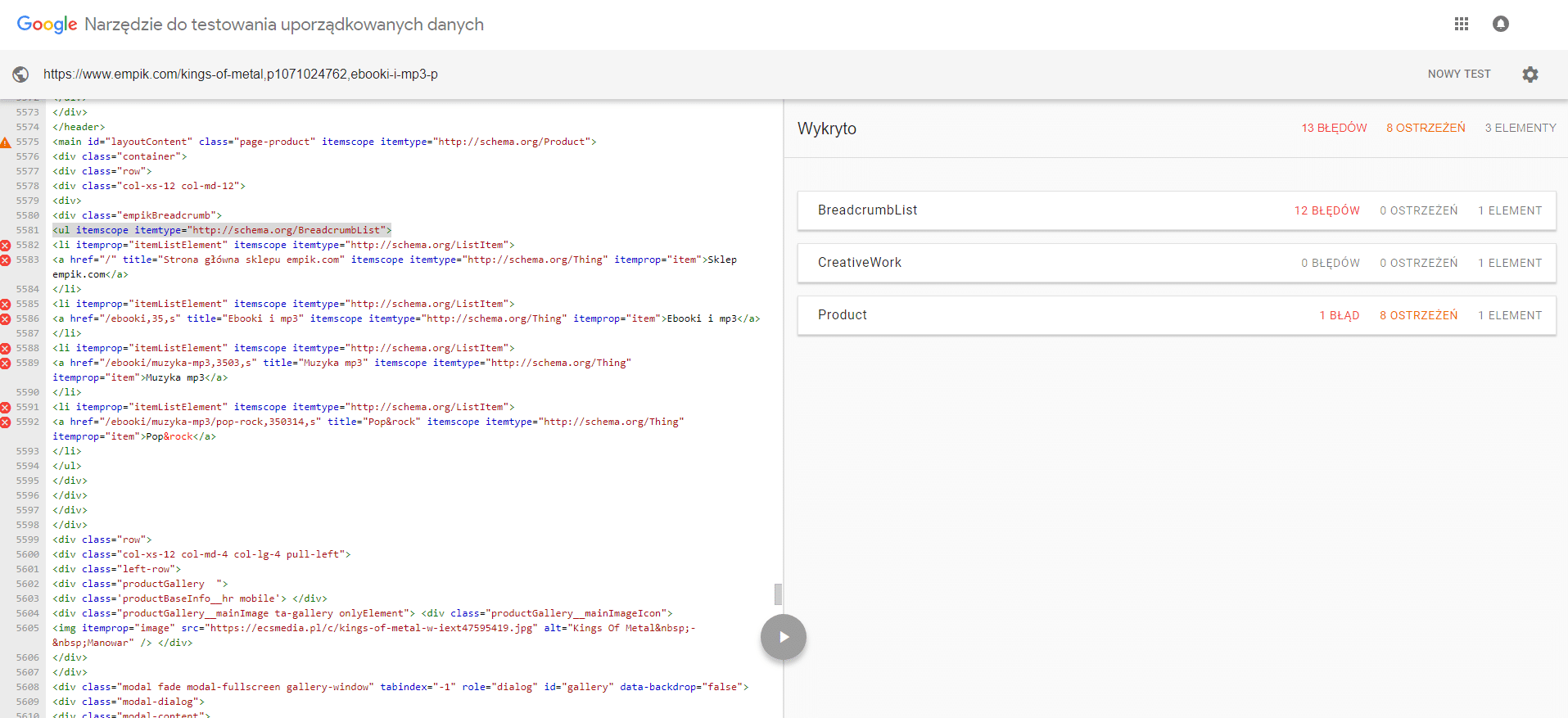

Dane strukturalne

Jeśli chcemy mieć pewność, że roboty wyszukiwarek prawidłowo potrafią odczytać wszystkie ważne dane znajdujące się na naszej stronie, to podczas jej audytu powinniśmy wykonać również analizę danych strukturalnych. Można to zrobić za pomocą darmowego narzędzia do testowania danych strukturalnych od Google, które jest dostępne pod adresem https://search.google.com/structured-data/testing-tool?hl=pl.

Analizuje ono daną podstronę i pokazuje jakie informacje Google rozpoznało i czy w ich zapis jest prawidłowy. W przypadku, gdy analiza za pomocą tego narzędzia nie wykaże żadnych danych strukturalnych, a na naszej stronie są umieszczone dane adresowe, opinie użytkowników, nawigacja okruszkowa, dane produktu, ocena strony lub produktu itp. to właśnie elementy, które można opisać za pomocą danych strukturalnych, aby zawierał dane interpretowalne przez roboty sieciowe. Wykorzystanie danych strukturalnych umożliwia Google wyświetlanie w wynikach wyszukiwania dodatkowych informacji takich jak np. graficzną prezentację opinii (gwiazdki ze średnią oceną, które wyróżniają wynik), która może dodatkowo przykuć uwagę użytkowników i wpłynąć na to, że odwiedzą właśnie naszą stronę.

Jeśli nasz serwis posiada już dane strukturalne, ale w analizie Google wskazane są błędy lub braki w kodzie, to również należy podjąć odpowiednie kroki i zmodyfikować kod źródłowy, tak aby dane były prawidłowo odczytywane.

Optymalizacja kodu pod tym kątem wymaga przynajmniej podstawowej wiedzy z zakresu programowania, więc najlepiej powierzyć to zadanie osobie mającej doświadczenie w tworzeniu i optymalizacji serwisów internetowych, bądź specjaliście SEO, który takie elementy wdraża.

Blokowanie stron o niskiej wartości

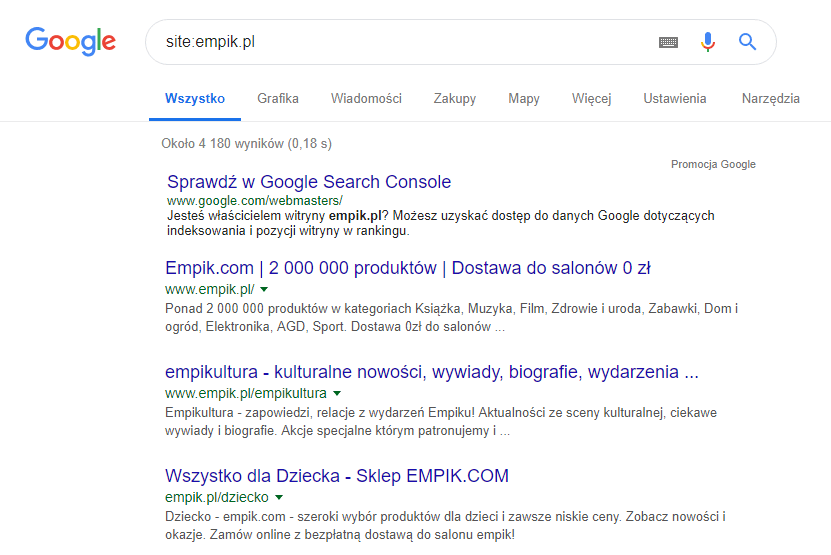

Nie możemy zapomnieć o weryfikacji czy Google nie indeksuje stron o niskiej wartości. Sprawdzenie tego punktu można zacząć od odpytania indeksu wyszukiwarki, czyli weryfikacji jakie podstrony zostały zaindeksowane przez roboty wyszukiwarek. Można to zweryfikować wpisując w wyszukiwarce Google polecenie “site:” a następnie bez odstępu wpisać naszą domenę np.: “site:empik.pl”.

Pozwoli nam to na orientacyjne określenie ile podstron zostało zaindeksowane przez Google. Kolejny krok to przejrzenie listy zaindeksowanych podstron. W przypadku małych stron zajmie to tylko chwilę, ale przy dużych sklepach i portalach złożonych z setek czy tysięcy podstron może wytrwać dłużej. Warto jednak poświęcić czas na jak najbardziej dokładną analizę, ponieważ może ona pomóc w oczyszczeniu indeksu z podstron o niskiej wartości dla Google, które mogą zaniżać ocenę całości serwisu. W przypadku wykrycia dziwnych adresów należy zweryfikować ich przydatność, a następnie jeśli mamy pewność, że nie powinny one być indeksowane zablokować je dla robotów wyszukiwarek. Blokadę możemy dodać na kilka sposobów. Zainwestuj w sukces swojego e-commerce – skorzystaj z naszych usług w zakresie pozycjonowania sklepów!

Plik robots.txt

By za jego pomocą zablokować indeksowanie strony wystarczy wpisać w nim komendę “Disallow: “, a następnie podać adres, który chcemy zablokować przed indeksowaniem. Jeżeli do zablokowania mamy wiele plików posiadających taki sam wzór adresu możemy również wykorzystać znak “*” do ich zapisu, który oznacza dowolny ciąg znaków. Zatem wpisanie poniższej reguły

Disallow: http://nazwadomeny.pl/zablokuj-mnie-id-*.html

Pozwoli na zablokowanie wszystkich URLi pasujących do powyższego wzoru czyli np.:

http://nazwadomeny.pl/zablokuj-mnie-id-1.html http://nazwadomeny.pl/zablokuj-mnie-id-38424.html http://nazwadomeny.pl/zablokuj-mnie-id-xyz123abc-pl.html

Reguły w pliku robots.txt pozwalają również na blokowanie całych katalogów za pomocą zapisu typu:

Disallow: /nazwa-katalogu-na-serwerze/

Blokując podstrony za pomocą pliku robots.txt należy być bardzo ostrożnym, ponieważ jeśli wstawimy blokadę katalogu, w którym znajdują się również ważne elementy strony (np. grafiki lub promowane podstrony), to zostaną one końcowo usunięte z wyników wyszukiwania, a dodatkowo Google może nie być w stanie wyrenderować prawidłowego wyglądu strony.

Meta tag robots

Drugą metodą blokowania podstron o niskiej wartości jest meta tag robots. Należy go umieścić w sekcji head i nadać mu na przykład poniższą postać:

<meta name="robots" content="noindex, follow" />

Powyższy znacznik informuje roboty wyszukiwarek, by nie indeksowały danego adresu, ale pozwala im na swobodne poruszanie się po danej podstronie i przechodzenie na inne podstrony, które są podlinkowane z blokowanego URL. Przy blokowaniu podstron serwisu jest to lepsze rozwiązanie niż plik robots.txt, ponieważ ten drugi blokuje cały dostęp do danej podstrony, zatem roboty wyszukiwarek nie mają dostępu do treści i linków umieszczonych pod blokowanym URLem. W przypadku, gdy część naszych podstron jest podlinkowanych tylko z blokowanego adresu, roboty wyszukiwarek mogą ich nie zaindeksować.

Jakie podstrony można uznać za niskiej wartości?

Z pewnością będą to podstrony bez żadnej użytecznej treści np. strony testowe, na których często umieszcza się treść “Lorem Ipsum”

Do podstron o małej wartości dla robotów Google można zaliczyć również strony koszyka w sklepach, podstrony filtrowania i sortowania wyników oraz wewnętrznej wyszukiwarki (o ile nie zadbaliśmy o umieszczenie na nich unikalnych treści i ich optymalizację), podstrony stanowiące duplikaty wewnętrzne, których nie można przekierować ani oznaczyć znacznikiem canonical, podstrony informujące o braku towaru, strony informacyjne o polityce plików cookies, podstrony służące do logowania, rejestracji, zmiany hasła itp.

Z uwagi, że nieprawidłowo zastosowana blokada indeksowania może spowodować usunięcie ważnych podstron lub nawet całego serwisu z wyników wyszukiwania zalecamy, by optymalizację serwisu pod tym kątem wdrażała osoba z doświadczeniem w tym zakresie.

Podsumowanie

Wykonanie audytu powyższych elementów jest dobrym wstępem do poprawy optymalizacji naszej strony www bądź sklepu internetowego, a docelowo widoczności serwisu w wynikach wyszukiwania. Jeśli jednak nie posiadamy podstawowej wiedzy z zakresu SEO i programowania, nasze działanie mogą wymagać dodatkowej weryfikacji, a nawet zmian, aby nie rzutowały na kolejne prace w zakresie promocji witryny. Najlepiej zatem po zakończeniu analizy poprosić o pomoc webmastera, specjalistę SEO lub agencję – można liczyć na weryfikację, ewentualne poprawki i sugestie odnośnie kolejnych elementów wymagające zmian pod kątem pozycjonowania.

Wypełnij formularz

Przygotujemy dla Ciebie bezpłatną wycenę!

Dodatkowo otrzymasz bezpłatnie dostęp do kursów z marketingu internetowego.